SEO Hacks für mehr Traktion

Hört sich immer gut an, oder: wenig Arbeit viel Ergebnis. Aber wie kommt man mit einfachen Kniffen und Prozessen zu dauerhaft mehr Zugkraft im SEO? Unsere Kollegin Anna hat auf der virtuellen SMX 2021 einen Vortrag gehalten, den wir hier als Beitrag zum Nachlesen posten.

Wer möchte der kann sich hier auch Annas Präsentation auf SlideShare ansehen.

Die Datei zum KNIME Workflow könnt ihr hier runterladen.

Hinweis: Der Workflow wurde aktualisiert und für die KNIME Version 4.5.1 erstellt. Die folgende Beschreibung beruht noch auf den initialen Schritten des SMX-Vortrags.

Viel Spaß!

Pragmatische Tipps für Low Effort und High Reward

Das ist der Untertitel zu dem Vortrag und was sich erstmal so locker liest, bedeutet eigentlich, dass man durch eine zielgerichtete Kombination der GSC-Leistungsdaten mit dem Crawling der Domain und mit dem Tool KNIME zu Workflows mit Hands-on-Optimierungspotenzialen kommt.

SEO Workflow zur Erhebung von Ad-Hoc Potential zur Klicksteigerung

Der hier gezeigte leicht reproduzierbare Workflow eignet sich insbesondere für Content-lastige Seiten, Shops, oder z.B. auch für einzelne Seitenbereiche der Website wie z.B. Ratgeber.

Bei Webseiten mittlerer Größen entfalten sich die Vorteile des Workflows am stärksten. Als Endprodukt bekommt man eine Arbeitsdatei mit drei Optimierungspaketen, die dann nur noch darauf wartet, abgearbeitet zu werden.

Der Prozess beinhaltet die Kombination der Datenmengen aus einem Crawl (hier wurde der Screaming Frog verwendet) und der GSC. Diese kombinierten Daten werden anschließend zusammengeführt und auf die relevanten Spalten reduziert, um an URL-Sets zu gelangen, welche das Optimierungspotential zur Klicksteigerung in der organischen Suche aufweisen.

In dem Vorgehen geht es daher um Optimierung von Bestandscontent. Es wird keine neue Reichweite erschlossen, sondern es müssen bereits ausbaufähige Rankings vorhanden sein.

Hier wird ein Prozess gezeigt, der einfach umzusetzen und zu wiederholen ist. Daher eignet sich das Vorgehen sehr gut als Regeltätigkeit. Egal, ob man als SEO in einer Agentur verschiedene Kundenwebseiten oder als Inhouse-SEOs wenige eigene Webseiten betreut.

Welchen Vorteil zieht man aus einem solchen Vorgehen?

- Tools wie z.B. die Google Search Console oder Crawlingtools sind reine Datenlieferanten ohne direkte Handlungsempfehlungen

- Bei unserem Prozess findet eine Vorqualifikation der URL-Sets nach individuellen Schwellwerten statt

- Durch clustern in Pakete sind die Maßnahmenempfehlungen leicht weiter zu bearbeiten

- Damit verliert man sich nicht in den Untiefen eines kompletten Crawls und behält sein Ziel immer im Blick.

KNIME Workflow zur Identifikation zur Optimierung von Low-Hanging-Fruits

- Einmal angelegt, ist der Workflow regelmäßig reproduzierbar.

- Die Schritte zur Manipulationen + Transformationen von Datenmengen müssen nicht immer neu erfolgen.

- Durch Benennung der Knoten + Notizen bleibt das Vorgehen langfristig nachvollziehbar + transparent.

- Der Workflow lässt sich leicht teilen

Überzeugt, aber keine Erfahrungen mit KNIME? Dann einfach unseren Blogartikel KNIME für Anfänger lesen!

Hier geht es zu unserer KNIME Schulung

Workflow zu Vorbereitung, Umsetzung, und Weiterverarbeitung der Ad-Hoc SEO-Maßnahmen

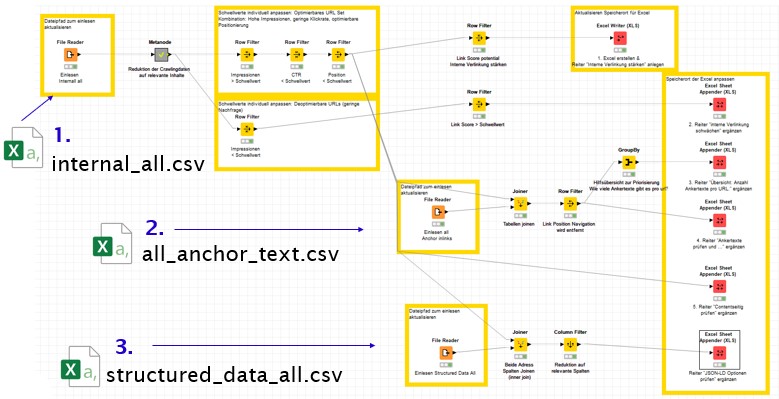

Grafisch dargestellt, ergibt sich ein Arbeitsprozess, der folgendermaßen aussieht:

Gehen wir also Schritt für Schritt vor und beginnen mit dem Crawling der Domain inklusive Anschließen der GSC API. Als Crawling-Tool verwenden wir hier den Screaming Frog.

Hinweis: Es kann natürlich auch ein anderes Crawling-Tool bei euch zum Einsatz kommen. Ist dies der Fall, muss der Workflow in KNIME dahingehend angepasst werden.

Anschließend werden 3 CSV-Dateien für die Weiterverarbeitung exportiert , und in KNIME importiert und hier kann man Schwellwerte individuell festlegen. Zum Schluss liegt es an einem selbst, die Arbeitsdatei und die Optimierungspakete (Content-, Link- und Datenpaket) zu prüfen und umzusetzen.

Schritt 1: Datenerhebung mit dem Screaming Frog & der Google Search Console

Für die erfolgreiche Abfrage der Daten müssen folgende Konfigurationen im Screaming Frog vorgenommen werden:

- Domain in den Screaming Frog eingeben

- Die Crawleinstellungen nach Bedarf konfigurieren

- Wichtig für das Spätere „Datenpaket“: Setzt den Haken zur Extraktion der JSON-LD Daten

Configuration > Spider Configuration> Extraction > Structured Data > JSON-LD

Im nächsten Schritt werden im Screaming Frog folgende Einstellungen vorgenommen, um die GSC API anzuschließen:

- Unter Punkt 1 wird ein API-Account für Google Search Console unter Configuration > API Access > Google Search Console > Connect to New Account

- In Punkt 2 wird in Date Range der gewünschte Zeitraum ausgewählt.

- Punkt 3 zeigt auf den Dimension Filter unter dem man verschiedene Dimensionsfilter ergänzen kann. Sinnvoll ist unserer Einschätzung nach hier Country auszuwählen, wenn es eine Zielregion gibt, die in der Webseitenausrichtung klar im Fokus steht.

- Anschließend startet ihr den Crawl

- Nach Abschluss des Crawls, startet ihr die Crawl-Analyse im Screaming Frog. Dies ist nötig, um die Link Score Werte für die spätere Auswertung zu bekommen.

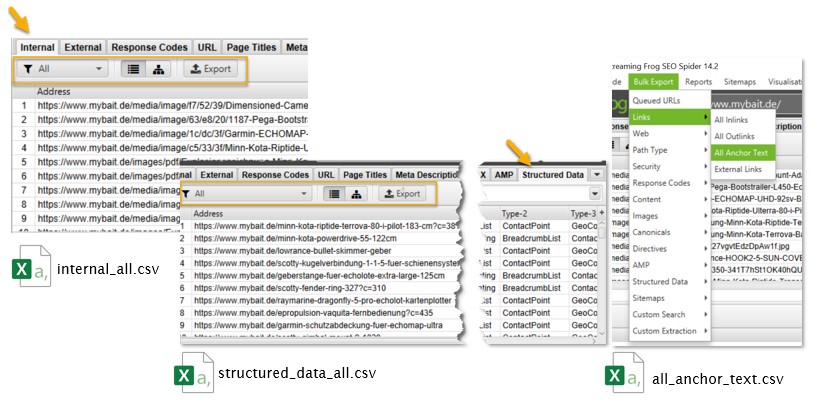

- Anschließend benötigen wir 3 CSV-Exporte zur Weiterbearbeitung: internal_all; structured_data_all; all_anchor_text

Wo Ihr die drei nötigen Exporte im Screaming Frog findet, haben wir hier skizziert:

Schritt 2: Weiterverarbeitung in KNIME zur Identifikation der optimierbaren und deoptimierbaren URL-Sets zur Klicksteigerung aus der organischen Suche

Danach kommt der zweite Teil unseres Workflows, bei dem mit KNIME gearbeitet wird. In diesem Schritt werden die erforderlichen Daten importiert und auf Basis individuell zu setzender Schwellwerte optimierbare oder deoptimierbare URL-Sets identifiziert.

Der KNIME-Workflow zum Einlesen und Segmentieren der Leistungs- und Crawldaten sieht folgendermaßen aus:

Den Workflow gibt es hier zum Download

Hinweis: Der Workflow wurde aktualisiert und für die KNIME Version 4.5.1 erstellt. Die folgende Beschreibung beruht noch auf den initialen Schritten des SMX-Vortrags.

In diesem KNIME-Workflow solltet ihr 3 Anpassungen vornehmen:

- Einlesen der drei CSV Exporte mittels dem Knoten File Reader

- Definition der individuellen Schwellwerte für Impressionen, Klickrate, Position

- Output Excel Datei erstellen & Arbeitsblätter ergänzen

1) Einlesen der drei CSV-Exporte mittels Knoten File Reader

Konfigurationshinweis für File Reader: Zunächst muss man mit einem Rechtsklick auf File Reader -> Configure die Konfiguration des Knotens öffnen (1). Danach empfiehlt es sich unter dem Punkt 2 den Haken bei Preserve user settings for new location zu setzen. Dann wählt man über „Browse“ den Pfad der exportierten CSV-Datei aus und klickt auf „OK“, um die Konfiguration zu speichern. Anschließend muss man die Ausführung des Knotens nur noch starten, z.B. mit F7. Dann wählt man über „Browse“ den Pfad der exportierten CSV-Datei aus und klickt auf „OK“, um die Konfiguration zu speichern. Anschließend muss man die Ausführung des Knotens nur noch starten, z.B. mit F7.

2) Definition der individuellen Schwellwerte für Impressionen, Klickrate, Position

Für die spätere Auswertungen definiert man auf Basis individueller Schwellwerte zwei verschiedene URL-Sets 1) optimierbare URL Sets (Oben), 2) deoptimierbare URL-Sets. Zur Segmentierung der URLs werden folgende Metriken der Google Search Console herangezogen:

- Impressionen

- Durchschnittliche Klickrate

- Durchschnittliche Position

Als optimierbare URLs sollen in die Betrachtung URLs einfließen, die in unserem Betrachtungszeitraum relativ viele Impressionen erzielen konnten, jedoch nur eine geringe Klickrate, aber gleichzeitig eine optimierbare Position haben. Als deoptimierbare URLs fließen v.a. URLs ein, die relativ wenige Impressionen erzielt hatten.

Mittels der Knoten Row Filter kann man Schwellwerte individuell festlegen. Hier geht man erneut in die Konfiguration (Rechtsklick-> Configure) und aktualisiert die dort definierten Ober- und Untergrenzen für jede Metrik. Anschließend klickt man auf „OK“ und führt die Knoten aus (F7).

3) Output Excel Datei erstellen & Arbeitsblätter ergänzenZum Festlegen des Namens und der Output-Location der Excel Arbeitsdatei startet man mit dem Knoten Excel Writer. Dies legt man ebenfalls über die Konfiguration fest. Alle weiteren Einstellungen können beibehalten werden. Anschließend klickt man auf „OK“, und führt den Knoten Excel Writer aus.

Anschließend werden der neu erstellten Arbeitsdatei weitere Arbeitsblätter hinzugefügt. Dies setzt man anhand der Knoten Excel Sheet Appender um. Hier geht man für jeden der 5 Excel Sheet Appender erneut in die Konfiguration, und wählt via Browse die eben neu erstellte Excel Datei aus, klickt auf „OK“ und führt die Knoten aus.

Nun ist man mit der Erstellung der Arbeitsdatei fertig.

Schritt 3: Prüfung und Umsetzung der Ad-Hoc SEO-Empfehlungen

Durch den Arbeitsprozess mit KNIME erhält man eine vorpriorisierte Auswahl an URLs. Für jedes URL-Set ergeben sich mögliche Handlungsempfehlungen aus folgenden Bereichen:

- Content-Paket

- Link-Paket

- Daten-Paket

Bedenkt, dass die Zusammensetzung der URL-Sets rein auf Basis numerischer Schwellwerte basiert. Daher solltet ihr im Anschluss alle URLs noch einmal manuell prüfen und bewerten, ob die Ausarbeitung der Maßnahmenempfehlungen für euren Kontext auch tatsächlich sinnvoll und umsetzbar sind.

Der letzte Schritt des Workflows ist es daher, die fertige Excel-Arbeitsdatei zu öffnen und die URL-Sets und die damit verbundenen Handlungsempfehlungen für jede URL zum einen auf Sinnhaftigkeit und zum anderen auf deren Umsetzbarkeit zu prüfen und anschließend umzusetzen.

Anbei eine Beispiel-Output-Datei:

Die Datei enthält für alle identifizierten URL-Sets die für die Bearbeitung der Optimierungs-Chancen relevanten Spalten, und die To-Dos lassen sich direkt an der Benennung der Arbeitsblätter ablesen.

Bearbeitung der Optimierungsdatei

Anschließend kann an loslegen und mit der Abarbeitung der Handlungsempfehlungen beginnen. Die ableitbaren Tätigkeiten lassen sich in folgende drei Arbeitspakete zusammenfassen.

- Link-Paket

- Content-Paket

- Daten-Paket

Beispiele aus der Praxis gefällig? Mit einem Blick in die Folien findet ihr von Folie 26 an für jedes dieser drei Arbeitspakete anschauliche Beispiele aus der Praxis.

Nachfolgend findet ihr eine Zusammenstellung, welche Tätigkeiten Ihr auf Basis der Optimierungs-Datei prüfen und umsetzen könnt.

Eine Übersicht der möglichen Prüfpunkte des Link-Pakets findet man hier:

- Interne Verlinkung stärken: gibt es URLs die stark nachgefragt werden, aber nur schwach intern verlinkt sind?

- Interne Verlinkung schwächen: gibt es URLs, die kaum nachgefragt werden, aber sehr stark intern verlinkt sind?

- Ankertexte prüfen & optimieren: Wie viele verschiedenen Ankertexte gibt es aktuell für die optimierbaren URLs? Lassen sich die Ankertexte vereinheitlichen und inhaltlich optimieren?

Eine Übersicht der möglichen Prüfpunkte des Content-Pakets findet man hier:

- H-Überschriftenstruktur: Ist für alle optimierbaren URLs eine suchrelevante H1-Überschrift vorhanden? Lässt sich die H-Überschriftenstruktur für alle optimierbaren URLs noch weiter optimieren?

- Titles + Descriptions: Sind die aktuellen Titles & Descriptions der optimierbaren URLs suchrelevant und klickattraktiv gestaltet?

- Content-Relevanz: Sind aktuell ausreichend Inhalte auf den optimierbaren URLs vorhanden? Bedient der aktuelle Inhalt die relevanten Terme, um für das Ziel-Keyword organisch gut positioniert zu sein?

Um diese Prüfungen optimal durchzuführen, empfehlen wir, für jeden dieser Punkte weitere Tools zur Hand zu nehmen: den Leistungsreport der GSC und ein Tool zur Content-Prüfung. Zur Prüfung der inhaltlichen Relevanz nutzen wir bei get:traction immer TermLabs.io. Anhand dieses Beispiels kann man erkennen, das noch sehr viele relevante Terme fehlen, die man mit weiterem Content ergänzen sollte.

Eine Übersicht der möglichen Prüfpunkte des Daten-Pakets findet ihr hier:

- Sind die verwendeten semantischen Auszeichnungen der optimierbaren URLs vollständig? Und auch ausschließlich mit JSON-LD umgesetzt?

- Sind die verwendeten semantischen Auszeichnungen der optimierbaren URLs sinnvoll?

- Welche weiteren semantischen Auszeichnungen für die optimierbaren URLs können noch ergänzt werden?

Ist diese Prüfung abgeschlossen, dann ist auch der Workflow abgearbeitet und ihr habt den Prozess abgeschlossen. Idealerweise beobachtet ihr nach der Umsetzung der ausgewählten Empfehlungen natürlich wie immer die Entwicklung. In der Regel können ein paar Wochen vergehen, bis die Maßnahmen ihre Wirkung entfalten, und Ihr euch dank der Optimierungsmaßnahmen über eine Steigerung der Klickrate freuen könnt. Damit ihr den SEO-Erfolg eurer Maßnahmen optimal beobachten könnt, empfehlen wir euch die optimierten URLs in euer SEO-Reporting zu integrieren.

Wie bereits erwähnt, handelt es sich bei dem Workflow um eine ideale Regeltätigkeit. Daher empfehlen wir, einen geeigneten Turnus zu wählen und die Auswertung regelmäßig quartalsweise oder halbjährlich zu wiederholen.

Viel Spaß beim Ausprobieren!

Anna Danzer

SEO CONSULTANT

Während meines Studiums der Wirtschaftswissenschaften mit den Schwerpunkten Marketing & Management an der Universität Passau faszinierte mich das Online-Marketing schon früh; zur gleichen Zeit sammelte ich erste Berufserfahrungen in einer ortsansässigen SEO-Agentur. Hier entdeckte ich schnell meine Leidenschaft für die organische Suchmaschinenoptimierung, da hier sowohl datengetriebenes Arbeiten als auch analytisches Denken von entscheidender Bedeutung sind. Die organische Suchmaschinenoptimierung ist in meinen Augen ein dynamisches Spannungsfeld zwischen Technik, Psychologie und Marketing. Des Weiteren steht und fällt eine langfristig hohe Sichtbarkeit von Webseiten mit der Verzahnung von Suchmaschinenkonformität und Nutzerorientierung. Als SEO-Consultant bei get:traction kann ich diesen Leitsatz optimal umsetzen.