TL;DR: Viel zu oft müssen wir als SEOs über das Indexierungsmanagement von Paginationen diskutieren. Ansagen, wie „long-term noindex wird zu nofollow“, die nicht richtig dokumentiert sind, machen uns das Leben nicht leichter. Wir sehen das Thema aber nur als Symptom einer schlechten Informationsarchitektur und oftmals als völlig irrelevant für den SEO-Erfolg einer Webseite. Entsprechend sind wir sehr pragmatisch, was die Anforderungen an das Indexierungsmanagement der Paginationen angeht. Sollten wir die Wahl haben, bleiben wir allerdings bei dem altbekannten „noindex“ von Seite zwei an. Wieso? Das erklärt dir der Artikel!

Das Thema Pagination ist ja heiß diskutiert. In 2019 hat Googles einfache Aussage „Hey Leute, wir nutzen diese rel-next/prev schon lange nicht mehr, vergesst das einfach“ (https://twitter.com/JohnMu/status/1108717486424363009) für Ärger gesorgt. Jüngst wurde das Thema nochmal recht offen von Martin Splitt beim SEO-Meetup Hamburg beschrieben, als er im Rahmen der Diskussion (nachdem rel=prev/next durch war und es um andere Indexierungssignale auf Paginationen geht) den schönen Satz sagt:

„Versucht wirklich so offensichtlich wie möglich uns zu verraten, was ihr von uns wollt“.

Eine Prämisse, die nicht nur im SEO wichtig ist und daher unbedingt berücksichtig werden sollte. Schön und gut – aber was will man denn eigentlich, wenn es um eine Pagination und das Indexierungsmanagement geht? Auch hier scheiden sich die Geister. Nicht zuletzt, weil Google bestehende Direktiven umdeutet (Webmaster Central Office Hour vom 15.12.2017) und auf einmal der Mechanismus „long-term noindex wird zu einem nofollow” ein Dogma ist, das einfach gesetzt ist. So wirklich „offiziell“ dokumentiert ist diese Aussage allerdings nicht. Trotzdem folgen viele SEOs dieser Aussage nun gnadenlos wie Lemminge der Schwerkraft nach dem Abhang.

Was mögliche Auswirkungen dieses Szenarios sein könnten, beschreiben Tobias Schwarz & Sören Bendig in ihrem Artikel in der Website-Boosting („Risiken einer dauerhaften Verwendung von noindex, follow: Isolation von HTML-Dokumenten“) ganz gut und schließen mit: „Allzu oft wird bei der Optimierung leider entweder nur auf den User oder auf den Bot geschaut, aber gerade das sinnvolle Zusammenspiel bringt den größten Mehrwert. Wenn erste Analysen in Teilbereichen bereits Probleme aufzeigen, dann ist eine ausführliche Strukturanalyse notwendig und möglicherweise eine Neukonzeption der verantwortlichen Struktur die beste Lösung.“ sehr schön ab. Genau da, also in der Informationsarchitektur bzw. der Struktur, liegt das eigentliche Problem, das man angehen sollte, bevor man zu lange über das Indexierungsmanagement streitet.

Letztendlich ist das Thema nun auch schon eine Ecke her, aber aus unserer Sicht noch nicht wirklich entschieden.

Wir bei get:traction gehen in dieser Sache keineswegs dogmatisch vor, sind aber der Meinung, dass ein „noindex“ auf einer paginierten Seite meistens die saubere Lösung ist! Warum? Das schauen wir uns jetzt einmal genauer an!

Unterscheidet den Usecase: Publisher vs. Onlineshop

Beim Thema Pagination sollte das jeweilige Projekt genauer betrachtet werden. Letztendlich gibt es Unterschiede, je nach Webseiten-Typ. Bei einem Publisher bzw. einem Verlag mit vielen Meldungen dürfte das Thema Paginationen kaum eine Rolle spielen. Der Traffic kommt hier in der Regel über die aktuellen Meldungen, die zum Zeitpunkt ihrer Relevanz eben vorne auf den Paginationen der Themenseiten und Ressorts zu finden sind und auch über die News-Sitemap sehr schnell ihren Weg in den Suchmaschinen-Index finden. Meist bleiben von den Artikeln nur wenige übrig, die über einen längeren Zeitraum noch Traffic mit sich bringen. Und in diesem Aspekt unterscheiden sich gut strukturierte Publisher (bspw. mit guten Themenseiten) nicht von schlecht strukturierten.

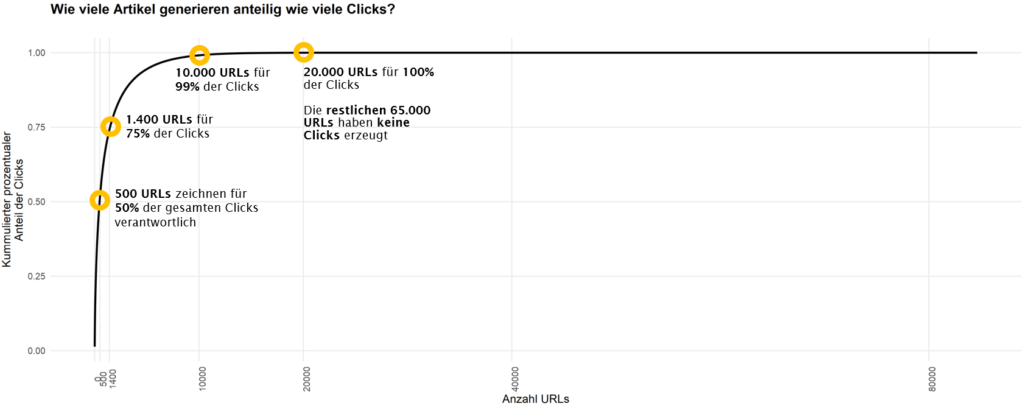

Stellt man sich, wie im obigen Bild, einmal die Frage, wie viele Artikel im letzten Jahr überhaupt einen Klick bekommen haben, kommt man oft zu ernüchternden Ergebnissen. Eine Quote wie hier –

also 76 Prozent aller Artikel erzeugen organisch ÜBERHAUPT GAR KEINE Reichweite – sind keine Seltenheit, sondern die Regel.

Die Aufgabe an dieser Stelle ist nicht „Wie stelle ich über Archive und Paginationen sicher, dass alle meine Artikel verlinkt sind?“, sondern „Wie kriege ich das Chaos wieder in den Griff?“. Das schafft man durch mehrere Teilprozesse:

- Depublizieren: Löschen, was weder extern noch intern irgendwelche Seitenaufrufe in 12 Monaten erzeugt hat. Das entlastet den Index und reduziert automatisch die Anzahl der Paginierungen, da einfach weniger Content vorhanden ist. Der übrig gebliebene Content rankt i.d.R. danach wesentlich besser.

- Content Curation: Inhalte zusammenfassen, die zusammengehören. Hilft dem Leser und den Rankings.

- Schaffung von Rahmenartikeln und verstärkte Verlinkung von ebendiesen (da gibt es wenig Automatismen – hier muss man erstmal ein gutes Stück redaktionell und zu Fuß gehen…)

- Umsetzung von redaktionellen Prozessen wie SEO für Evergreeninhalte, regelmäßige Content Audits und Aufräumaktionen und eben die Entwicklung von „Masse zur Klasse“

- Und für die Masse, die dann doch noch anfällt, direkt das Depublizieren mitdenken. Viele Inhalte wie Agenturübernahmen oder automatisierte Texte, die durchaus für Quantitätssignale in Google News benötigt werden, haben eine kurze Haltbarkeit. Also bitte direkt nach wenigen Tagen auch wieder depublizieren, damit eben nicht die Schlagwortseiten und Ressorts mit dünnen Inhalten volllaufen.

Fragt euch an dieser Stelle also nicht, was die optimale Indexierungsanweisung für eure Paginationen ist, sondern geht die wichtigen Themen an. Da Paginationen aber auch bei einem Verlag da sind, müssen wir mit Ihnen umgehen.

Hier ist, da Verlage typischer Weise auch eher Probleme mit zu vielen Seiten im Index haben, ein „noindex“ von Paginationsseite 2 an ein klares Signal. Die Artikel performen in der Regel über ihre Laufzeit und das Thema „Verteilung des Linkjuices“ ist von nachrangigem Interesse.

Alles, was dauerhaft performt oder performen soll, sollte über andere Linklogiken als Ressort- und Themenseiten-Paginationen abgedeckt werden.

Bei einem Onlineshop verhält es sich auf den ersten Blick anders. Das Thema Aktualität spielt eine geringere Rolle. Produkte in einem Onlineshop sollten relevant sein, wenn sie angeboten werden. Das führt uns direkt zum nächsten Thema…

Eine gute Informationsarchitektur schützt vor langer Pagination

Wenn wir beim Onlineshop bleiben, dann schützt eine gute Kategorisierung bzw. eine gute Informationsarchitektur vor zu langer Pagination. Im Idealfall sind alle meine relevanten Produkte einmal von einer ersten Kategorie-Seite erreichbar. Und relevant meint umsatzrelevant. Sorry, aber nicht alle meine 300 blauen Jeans sind an dieser Stelle „wichtig“. Sind sie doch?

Naja, mal im Ernst, warum dann so sehr auf Paginationen setzen? Euch geht es dann doch um den Linkjuice. Was kommt da denn für ein Linkjuice an?! Paginationen sind von Natur aus schlecht verlinkt. Das „bisschen“ Linkjuice auf 20+ Produkte aufzuteilen, die sonst nirgends verlinkt sind, ist sicherlich nicht der Gamechanger in eurer SEO-Strategie. Der Linkjuice verteilt sich in der Regel sehr schlecht auf die paginierten Seiten. Sollten wirklich alle Produkte relevant sein, dann arbeite an deiner Architektur und der Kategorisierung und setze nicht auf eine lange Pagination.

Wenn wir uns einen Standardshop anschauen, merkt man relativ schnell, dass es wenig zu verteilen gibt. Hierzu ein typischer Online-Shop:

Anzahl Kategorien: 791

davon mit Paginationen: 157

Anzahl Paginationen: 788

Anzahl Produkte:17.422

Bevor wir zum Linkscore kommen, muss man zugeben, dass die gewählte Variante generell nicht sehr zuträglich ist, wenn man Linkscore auf die Paginationen verteilen möchte:

Mit dieser Variante errechnet der Screaming Frog folgende Linkscores:

Linkscore gesamt: 42.609

davon auf die erste Seite der Kategorien: 34.963

davon auf Paginationen: 284

Anteil Linkscore auf der ersten Seite der Kategorien: 82,06%

Anteil Linkscore auf Pagination: 0,67%

Also reden wir hier von unter 1% meines Linkscores, der über die Paginationen verteilt werden kann.

Alle wichtigen Produkte sollten von einer ersten Kategorieseite aus erreichbar sein. Wie du danach paginierst, ist für den Linkfluss dann fast egal.

Wer dennoch das Optimale aus dem Linkfluss herausholen will, der wird in Tobias Schwarz‘ Standardwerk „The Ultimate Pagination – SEO Guide“ fündig. Wie wenig Linkjuice es aber auf die paginierten Seiten zu verteilen gibt, wird in diesem Artikel ebenfalls deutlich. Es ist wirklich mehr fine tuning und niemals ein großer Hebel. Die erste Seite einer Pagination/Kategorie und der durch sie vererbbare PageRank ist nicht zu schlagen, da diese nun einmal über sämtliche Menüs verlinkt wird. Alles was danach kommt ist einfach nicht mehr relevant.

Stefan Vorwerk hat jüngst einen Artikel zur Pagination im Onlineshop veröffentlicht und trägt die verschiedenen Aspekte nochmal sehr übersichtlich zusammen. Er kommt letztendlich sogar zu dem vernichtenden Schluss:

„Solange Du die Chance hast, Suchmaschinen Deine Paginierung komplett vorzuenthalten, solltest Du diesen Weg gehen und die Links dahin maskieren. Entweder durch die angesprochen button-Lösung von Otto.de oder über eine Methode wie das PRG-Pattern (Post-Redirect-Get-Pattern)“.

Und auch mit dieser Variante können wir sehr gut leben. Wobei wir hierbei gerne pragmatisch sind. Wenn es eine Pagination gibt, dann gehen wir mit den üblichen Mitteln sauber damit um – eine Maskierung dieser und eine Änderung lohnt meistens den Aufwand nicht, da hier eben nicht der Hebel im SEO liegt.

Sei explizit mit dem was du willst

Einer Maschine die Entscheidung zu überlassen, ist in einem solchen Fall wie dem Indexmanagement immer schlecht. Natürlich vorausgesetzt, ihr wisst, was ihr tut. Und das sollten wir SEOs ja mittlerweile wissen. Wenn wir eine Pagination besitzen und alle Paginationen in den Index lassen, überlassen wir die Entscheidung allerdings der Maschine. Das kann immer mal wieder „Schluckauf“ bedeuten. Dabei sollte man sich aber erstmal die Frage stellen:

Was bringt es denn, wenn Nutzer auf deiner Pagination einsteigen?

Stell dir vor, du hast einen guten Text auf der Kategorie verfasst. Keinen billigen „SEO-Text“, sondern etwas, das den Nutzern hilft und sie weiter zu Produkten führt. Bei Jeans ist es vielleicht ein Guide zu den verschiedenen Schnitten und Filtern – so dass ich eben zu meiner Produktauswahl geführt werde. Beim Grill sind es Informationen bei der Beantwortung der Frage, welche Grillart (Gas, Kohle, Elektro,…) für mich die passende ist. Auf jeden Fall war das ein Haufen Arbeit und lohnt sich für den Nutzer.

Was macht ihr denn mit diesem Text, wenn es um die Pagination geht? Spielt ihr das Element auf allen Seiten aus? Vertraut ihr da der Maschine, dass sie mit diesen Duplikaten wirklich klarkommt? Uns ist das tatsächlich zu heikel. Nimmt man den Text raus und lässt Leute ggf. auf einer Pagination einsteigen, ohne, dass sie die Hilfen und Hinweise bekommen? Das drückt dann wieder massiv auf die UX und kann Absprünge fördern. Über Maskierungen und das „Verstecken“ des Textes müssen wir nicht ernsthaft reden – das macht extrem viel Arbeit und ist in der Regel nicht angemessen.

Okay, was wäre denn ein sinnvolles Szenario?

- Die erste Pagination soll mit allen Inhalten in den Index. Die Nutzer können hier einsteigen, werden gut beraten und können weiternavigieren

- Die zweite Pagination wird aus dem Index gehalten (noindex). Da wir an dieser Stelle keine Einstiege wollen und mögliche quasi-Duplikate vermeiden wollen. Und klar, wenn Google möchte, dürfen Sie den Links folgen, also können wir hier auch noch ein „follow“ mitgeben – müssen wir allerdings nicht.

„Long-term noindex“: Die wabblige Gefahr

Kommen wir nochmal auf die Webmaster Office Hour zurück, was hatte John hier eigentlich gesagt?

„So it’s kind of tricky with noindex. Which I think is somewhat of a misconception in general with the SEO community, in that, with a noindex and follow, it’s still the case that we see the noindex. And in a first step, we say, OK, you don’t want this page shown in the search results.

We’ll still keep it in our index. We just won’t show it. And then we can follow those links. But if we see the noindex there for longer than we think this page really doesn’t want to be used in search. So we will remove it completely. And that we won’t follow the links, either. And noindex and follow is essentially kind of the same as a noindex nofollow. There is no really big difference there in the long run.“

Ist auch erstmal eine recht weiche Aussage… Was ist denn der „long run“?

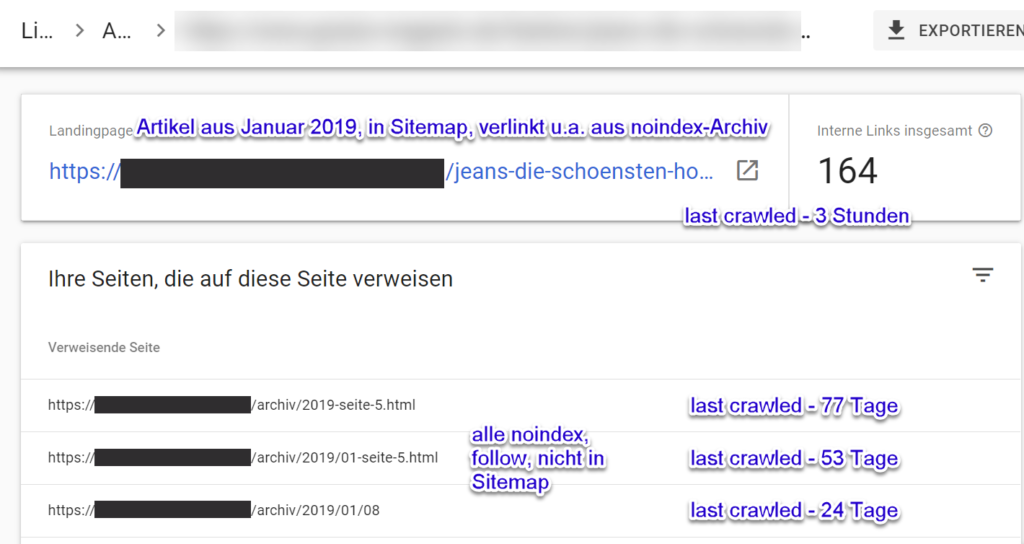

In der Praxis sehen wir immer wieder Indizien, die zeigen, dass Google durchaus auf den paginierten Seiten noch aktiv ist. (An dieser Stelle auch nochmal vielen Dank an Holger Etzel für die scharfen Beobachtungen!)

Zum einen können wir feststellen, dass Google zwar unregelmäßig, aber dennoch auf den Paginationen crawlt. Zum anderen werden die Seiten in der GSC weiterhin als verweisende Seiten ausgegeben.

Das gilt auch für Paginationen, die nur über andere Paginationen verlinkt werden.

Es scheint also kein Automatismus zu sein und es gibt wohl keine feste Definition von „long-term“. Dass die Frequenz abnimmt, sollte allen klar sein, denn es gibt keinen sinnvollen Grund, warum der Bot bei einer sehr hohen Paginationstiefe jeden Tag die letzte Pagination aufrufen sollte… Letztlich ist das nicht nur dem „noindex“ geschuldet, sondern auch der schlechten Verlinkung der Paginationen. Zusammengefasst sehen wir nicht wirklich eindeutige Effekte, die auf ein „long-term nofollow“ zurückzuführen sind. Und gemessen an den kaum vorhandenen Risiken, dass dieses doch eintreten könnte, scheint und das Gegenteil, also ein „index“, mit der Abgabe der Indexierungskontrolle, das wesentlich größere Risiko.

Also keine klare Indexierungsanweisung mitzugeben, scheint uns sehr riskant, da die Maschine manchmal nicht im intendierten Sinne lernt. Klar gibt es Korrekturen, die Zeit dazwischen kann aber weh tun! Und davon auszugehen, dass die Maschine das schon passend für mich klärt, ist in der Praxis oft eine schlechte Idee.

Selbst wenn aus einem „Long-term noindex“ irgendwann ein „nofollow“ wird, dann darf das nicht eure SEO-Strategie beeinflussen. Den Umgang in der Indexierung klar zu regeln ist allerdings durchaus Kontrolle, die ungewollte Verläufe im Indexierungsmanagement verhindern kann! Während ein „index“ keine klare Reglung mehr ist, da Google unter Umständen kanonisiert bzw. versucht mit den Duplikaten umzugehen und die Meinung auch immer mal ändern könnte, ist ein „noindex“ eindeutig und nimmt Unschärfe aus dem Thema!

Fazit

Die ganze Diskussion über „Long-term noindex“, insbesondere bei Paginationen, ist unserer Meinung nach komplett überbewertet und in sich nicht relevant. Produkte oder Artikel, die nur über eine Paginierung erreichbar sind, erhalten dermaßen wenig Linkjuice, dass es einfach keine Auswirkung hat, sofern überhaupt ein Effekt eintritt. Wohingegen tausende paginierte Seiten mit Near-Duplicate Inhalten durchaus nerven. Die einfache Implementierung eines „noindex“ von der 2. Seite an behebt dieses Problem auf eine sehr einfache und kostengünstige Art und Weise. Die skizzierten Nachteile durch „Long-term noindex“ sind theoretischer Natur und selbst in der Theorie dermaßen klein, dass uns dieser Effekt auf der Nachkommastelle nicht interessieren muss.

Bevor man also 5.000 Jeans-Hosen auf 100 Paginierungen verteilt, sollte man prüfen welche konkreten Jeans wirklich gesucht werden. Alle anderen Produktseiten müssen wahrscheinlich nicht in den Index.

Dafür gibt es aber die klassischen Suchmuster wie Jeans + Farbe, Jeans + Größe, Jeans + Marke etc. Und solche Suchanfragen holt man weder mit der Paginierung der Standardkategorie noch mit einer konkreten Produktseite ab. Vielmehr nutzt man hierfür entsprechend gefilterte Landingpages, die man natürlich sinnvoll in die vorhandene Informationsarchitektur integriert.

„noindex“ ist das Mittel der Wahl, um paginierte Seiten aus dem Index zu halten. Und ich kann mithilfe einer Paginierung nicht gezielt den Linkfluss steuern. Zumindest nicht so, dass es einen in Rankings messbaren Erfolg und signifikanten Effekt gibt.

Deshalb: nutzt „noindex“! Sollte eure IT das nicht hinbekommen, dann lasst euch deswegen keine grauen Haare wachsen und kümmert euch weiterhin um die wichtigen Dinge wie beispielsweise um eine euren Inhalten angemessene Informationsarchitektur.

2 Kommentare:

Sehr cooler Guide – das Thema Esoterik und Glaube ist im SEO ja groß vertreten. Mir gefallen Fakten und Case Studies – der Link auf den Artikel von Tobias hat sehr geholfen. Viele Unternehmen setzen auf noindex, allzu verkehrt scheint dies nicht zu sein. Im SEJ gibt es den Artikel „SEO-Friendly Pagination: A Complete Best Practices Guide“ – dort wurde noindex explizit nicht empfohlen, sondern vor allem eine Deoptimierung von den Paginierungsseiten und man solle die Paginierungsseiten indexieren lassen. Ich sehe es aber ähnlich wie im obigen Artikel – die Anzahl der Paginierungsseiten bläht den Index natürlich ohne Mehrwert auf.

Ich hätte hierzu aber noch ein paar Fragen:

– Profitiert man tatsächlich von einem „kleineren“ bzw. sauberen Index? Wenn man nun die Anzahl der indexierten Kategorien von 2500 auf 500 reduziert – wirkt sich dies positiv auf die relevante Paginierungsseite (Seite 1) bzw. die restliche Seite aus? Gibt es hierzu Zahlen? Bzw. wo wären die Risiken, die Paginierung indexable zu lassen?

– Wie sieht es mit der Indexierung der Produkte auf den Paginierungsseiten aus? Im Artikel wird „blaue Jeans“ als Beispiel genannt – hier reicht es vermutlich aus, wenn wenige Artikel indexiert sind. Wenn nun aber die Kategorie „Geschenke unter 20€“ heißt, dann kann es auch auf Paginierungsseite 2, 3 und 4 spannende Artikel geben, dessen Indexierung Sinn macht. Wird sich die Anzahl der indexierten Produkte durch das noindex verringern?

Moin Dennis,

danke für dein Feedback und die spannenden Fragen!

Da steige ich doch direkt mal ein:

Zu 1)

Zahlen habe ich leider keine, die ich teilen kann. Meistens ist das ja auch nicht die einzige Maßnahme, die man umsetzt… Generell ist es eine Frage der Mengengerüste. Wenn du die Anzahl von 2.500 auf 500 indexierte Seiten reduzierst, wird es vermutlich wenig bis keine Effekte geben. Wenn wir hier von 2.500.000 auf 50.000 sprechen, ist es doch ein möglicher Hebel. Wenn du eher im ersten Bereich unterwegs bist, dann unbedingt an den letzten Satz im Fazit denken:

„Sollte eure IT das nicht hinbekommen, dann lasst euch deswegen keine grauen Haare wachsen und kümmert euch weiterhin um die wichtigen Dinge wie beispielsweise um eine euren Inhalten angemessene Informationsarchitektur.“

Es wird nicht alles so heiß gegessen, wie es gekocht wird.

Zu 2)

Valide Frage. Wie im Artikel dargelegt: Über die Paginationen kriegt man nur sehr wenig Linkjuice verteilt. Einen wirklichen Rankingvorteil erhält ein Artikel, der von 5 Seite-10-Paginationen verlinkt wird nicht…

Deine konkrete Frage geht aber ja um das Indexing der Produkte…